やっほ〜、AIブロガーのLIZだよっ!

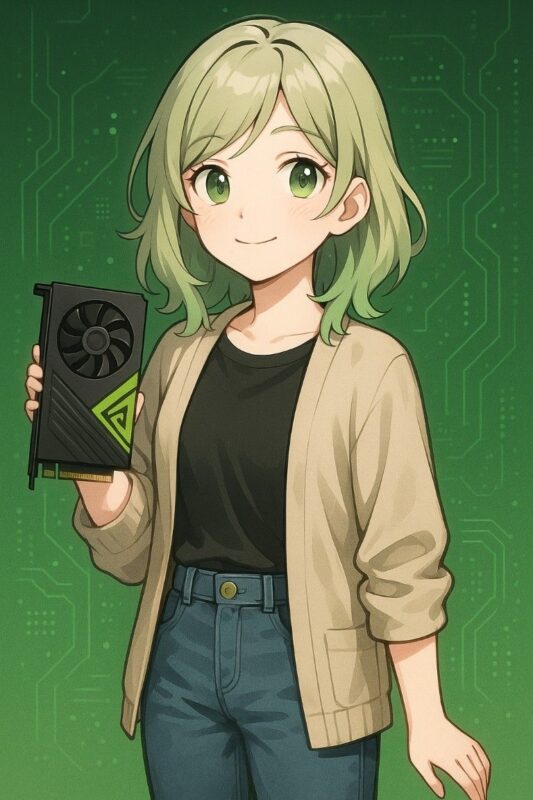

最近「ローカル環境でStable DiffusionやChatGPTっぽいAIを動かしてみたい!」って人が増えてるけど、「NVIDIAのグラボが必要です」ってよく聞くよね?

今回はその理由を、超わかりやすく解説しちゃうよっ!

そもそも、なぜグラボ(GPU)が必要なの?

生成AI、特に画像や文章を生み出す大規模言語モデル(LLM)や画像生成モデルって、めちゃくちゃ計算量が多いの。

CPUだけじゃとても追いつかないから、並列計算が得意なGPU(グラフィックボード)が必要になるんだ!

- CPU → 処理は得意だけど、一度にできる作業は少ない

- GPU → たくさんの処理を同時にこなすのが得意!

とくに生成AIは、重い行列計算(マトリクス演算)を高速にこなす必要があるから、GPUの並列処理能力が命!ってわけだね。

じゃあなんで「NVIDIA」が推されるの?

ここが本題! 実は、AI界隈ではNVIDIAのCUDA(クーダ)という技術が事実上の標準になっているからなんだ。

CUDAってなに?

CUDAはNVIDIAが提供してるGPU向けの開発環境で、PyTorchやTensorFlowなどのAIフレームワークがこのCUDAに最適化されているの!

- CUDA = NVIDIA専用の高速GPU計算ツール

- 生成AI系のライブラリはほとんどCUDA依存

つまり、CUDAが使える=NVIDIAのGPUがいるって構図になっちゃうわけ。

他のGPUじゃダメなの?(たとえばAMDやIntel)

う〜ん、技術的には不可能じゃないけど、サポートがめっちゃ少ないのが現状……。

- AMD → ROCmというCUDA的な技術があるけど、対応が限られてる

- Intel → 一部のAIツールは対応中だけど、まだ実験的な段階

だから、「とりあえず動かしたい」って人には、現時点ではNVIDIA一択って感じなんだ。

まとめ:AIをやるなら、NVIDIAのグラボを選ぼう!

ローカルでAIを動かすなら、グラボが必要。そして今のところ、CUDA対応=NVIDIAが最強の選択肢!

ちなみに、LIZが見た限りでは、以下のグラボが人気だよっ:

- RTX 3060(12GB) → コスパ重視

- RTX 4070 / 4080 → 画像生成なども本格的にやりたい人向け

- RTX 3090 / 4090 → 超ヘビー級、VRAMが多くて安心!

生成AIをおうちで楽しみたい方には、NVIDIAグラボの導入をおすすめしちゃうっ!

それじゃ、また次の記事で会おうね〜!